一、《DanceTrack: Multi-Object Tracking in Uniform Appearance and Diverse Motion》

作者: Peize Sun, Jinkun Cao, Yi Jiang, Zehuan Yuan, Song Bai, Kris Kitani, Ping Luo

The University of Hong Kong, Carnegie Mellon University, ByteDance Inc

论文链接:https://arxiv.org/pdf/2111.14690.pdf

Github:https://github.com/DanceTrack/DanceTrack

1、摘要

当前的多目标跟踪采用检测器来进行目标定位,并用ReID模型来实现数据关联。然而在现在的MOT Challenge数据集中,目标的外观是具有足够的区分性的,而这种区分性使得ReID模型很容易区分目标,实现数据关联。此外,当前的数据集中目标的运动模式比较简单,目标运动都可以被近似为匀速线性运动。而这种目标与现实场景中的数据关联是存在一些bias的,我们实际中通常跟踪的目标具有相同的外观表征,同时其运动姿态也会更多样。为此,本文作者提出了一个“DanceTrack”的数据集,希望其能提供一个更好的平台来开发更多的MOT算法,更少地依赖于视觉辨别,更多地依赖于运动分析。

2、方法

在上述中,已经提到了DanceTrack的提出动机,下图也是数据集中的一些示例。

以下是DanceTrack与MOT Challenge数据集的比较。

🔺在论文中也给出了很详细地分析,这个数据集的提出也说明了未来多目标跟踪研究的一个趋势,会去关注运动更加复杂,目标外观更相似的场景(后续的SoccerNet也有相似的Motivation)。

二、《SoccerNet-Tracking: Multiple Object Tracking Dataset and Benchmark in Soccer Videos》

作者: Anthony Cioppa, Silvio Giancola, Adrien Deliege, Le Kang, Xin Zhou, Zhiyu Cheng, Bernard Ghanem, Marc Van Droogenbroeck

University of Li`ege, KAUST, Baidu Research

论文链接:https://arxiv.org/pdf/2204.06918.pdf

Github:www.soccer-net.org

1、摘要

在足球视频中跟踪物体对于收集球员和球队的统计数据非常重要,无论是估计总距离、控球还是队形。视频处理可以帮助自动提取这些信息,而不需要任何携带型传感器,因此适用于任何体育场上的任何球队。然而,当前的数据集来测评这个问题是比较困难的。因此,在本项工作中,我们提出了一个新的多目标跟踪数据集,由200个序列组成,每个序列30秒,代表具有挑战性的足球场景,和一个完整的45分钟的半场用于测评长期跟踪。该数据集完成了目标框和轨迹ID的完成标注,允许各种方法在各基准上做测评。该数据集也验证了当前MOT方法在这种快速运动和严重遮挡的领域中并没有很好的解决。因此作者也希望通过该数据集的提出来促进该部分研究的进行。

2、方法

SoccerNet的数据集示例如图所示。

以下是SoccerNet与MOT数据集的比较。

三、《MeMOT: Multi-Object Tracking with Memory》

作者: Jiarui Cai,Mingze Xu, Wei Li, Yuanjun Xiong, Wei Xia, Zhuowen Tu, Stefano Soatto

University of Washington,AWS AI Labs

论文链接:https://arxiv.org/pdf/2203.16761.pdf

1、摘要

我们提出了一种在线跟踪算法,在一个公共框架下执行对象检测和数据关联,能够在长时间跨度后链接对象。这是通过保留一个大的时空内存来存储被跟踪对象的ID Embeddings,并根据需要自适应地从内存中引用和聚合有用的信息来实现关联。该模型称为MeMOT,由三个主要模块组成,它们都是基于Transformer的:1)、假设生成(Hypothesis Generation),在当前视频帧中生成目标proposals;2)、内存编码(Memory Encoding),从每个被跟踪对象的内存中提取核心信息;3)、内存解码(Memory Decoding),同时解决目标检测和数据关联任务,进行多目标跟踪。当在广泛采用的MOT基准数据集上进行评估时,MeMOT观察到非常具有竞争性的性能。

2、方法

🔺这篇文章的特点是通过Transformer的结构搭建了一个端到端的MOT框架,不需要后处理,性能和当前的SOTA比不是很高,但是具有一定的竞争力。作者在文中没有提到推理速度,感觉这个框架速度应该是一弱项。

要理解这个框架,主要是了解作者提出的三个模块。

1)假设生成(Hypothesis Generation):该模块通过Transformer的Encoder和Decoder生成一组proposal embeddings。这组embeddings有两个作用,一个是表示当前帧新出现的一些目标,另一个是为已经在跟踪状态的目标提供新的位置信息和外观信息。

2)内存编码(Memory Encoding):这个模块通过Cross-Attn Module来维护每一个instance的两个特征,一个关注短时信息,一个关注长时信息,最后把他们concat在一起去提取每一个instance的特征。长时特征是做了动态更新的,但是作者在文中没有说明更新的方式。

3)内存解码(Memory Decoding):将track的embedding和embedding proposal拼接起来,作为Q,并用当前帧的特征做K和V,通过一个Solver直接预测出Bounding Box,Objectness Score和Uniqueness Score。并通过这些值的组合直接获得最后的检测和数据关联结果。

四、《Learning of Global Objective for Network Flow in Multi-Object Tracking》

作者: Shuai Li,Yu Kong,Hamid Rezatofighi

Rochester Institute of Technology,Monash University

论文链接:https://arxiv.org/pdf/2203.16210.pdf

1、摘要

这篇工作研究了基于最小代价流公式(MCF)的多目标跟踪问题,并将其视为一个线性规划的实例进行研究。根据给出的计算性推理,MCF的成果跟踪极大地依赖于底层线性的可学习代价函数。以往的研究大多数聚焦于如何在训练过程中考虑两帧信息来学习代价函数,因此学习到的代价函数对于MCF来说是次优的。在推理过程中,必须在多帧上考虑进行数据关联。为了解决这一问题,本文提出了一种新的可微框架,通过解决一个双层优化问题将训练和推理相关联。其中底层解决了一个线性程序关联的问题,上层为一个包含全局跟踪结果的损失函数。可微层通过梯度下降进行反向传播,明确地学习和正则化全局参数化代价函数。通过这种方法,我们能够学习一个更好的全局MCF目标跟踪器。在MOT16、MOT17和MOT20上,与目前最先进的方法相比,本文的跟踪器取得了具有竞争力的性能。

2、方法

在这个方法中,作者先通过已有的网络提取目标定位信息,和每一个目标的外观特征。这些外观的特征会构建一个有向的图(方向和时序方向相同)。一个MLP层用于回归不同目标之间的连接概率。在训练过程中通过全局最优化的方法来构建损失优化MLP的参数,而在推理过程中,可以通过训练好的MLP网络直接预测结果进行tracking。

全文的推理部分比较多,但是全是涉及怎么通过全局最小代价的方法来训练MLP的。需要细致了解该工作可以去看原文。本博客较关心的是作者用了MLP做了什么,输入是什么,最后怎么推理。

MLP主要用于预测两个detection结果之间是否可以关联,如果可以关联会预测出一个概率,其式子如下:

![]()

其中eij表示的是两个detection之间的边是如何构建的(包括尺度、中心距离、框的IOU、embedding的距离等),如下式:

在推理的时候,文中提到会利用基于一个长度为50帧~150帧的批次进行跟踪(预测连接概率,算最小代价流)。并用了Gurobi求解器来获得最后的数据关联结果。由于每一个批次都覆盖了重复帧,所以可以把短轨关联成长轨。

在后处理中作者还用了单目标跟踪器。

五、《Global Tracking Transformers》

作者: Xingyi Zhou,Tianwei Yin,Vladlen Koltun,Phillip Kr¨ahenb¨uhl

The University of Texas at Austin,Apple

论文链接:https://arxiv.org/abs/2203.13250

代码链接:https://github.com/xingyizhou/GTR

1、摘要

我们提出一种新的基于Transfomer的结构用于全局多目标跟踪。我们的网络把一段短的视频序列作为输入,并预测所有对象的运行轨迹。其核心部分是一个全局tracking transformer,用于操作序列中所有帧中的目标。Transfomer网络对所有帧中的对象特征进行编码,并使用queries将它们分组为轨迹。轨迹的queries是来自单个帧的对象特征,并自然地产生独特的轨迹。我们的全局tracking transformer不需要中间的成对分组或组合关联,并且可以与目标检测器联合训练。它在流行的MOT17基准测试上取得了具有竞争力的性能,有75.3MOTA和59.1HOTA。更重要的是,我们的框架无缝地集成到最先进的大型vocabulary检测器中,以跟踪任何对象。在具有挑战性的TAO数据集上进行的实验表明,我们的框架改进了基于成对关联的方法。

🔺本文的Motivation是搭建个网络可以直接从32帧的图像中学习一种匹配结果,而不是逐帧做一个匹配。

2、方法

图中所示的是所提出的Global Tracking Transformer。其中F表示的是多帧的detection结果所提取的特征(其中N表示数量,D表示维度),Q表示用来检索的tracklet的特征(其中M表示数量,D表示维度)。通过Transformer的方式,直接预测获得一个匹配结果G,其中的数值预测每一个轨迹和每一个目标的关联关系,即 git(qk, F) ∈ R表示第t帧第i个目标与该轨迹的关联关系,该值为0表示这个目标与该轨迹没有关联关系。

在获得了G矩阵之后,在每一帧中单独对同一个轨迹的匹配分数做一次Softmax,得到:

通过找最大的概率,可以直接获得一条轨迹。在训练过程中,作者通过最大化PA来让网络学会这种能力。

而在测试过程中,感觉和DeepSort的过程依然比较像,不同的是Deepsort直接用了embedding的距离来构建匹配矩阵,而这个是通过transformer网络所预测出来的PA,之后用Hungarian来保持唯一的匹配结果。

六、《Unified Transformer Tracker for Object Tracking》

作者: Fan Ma,Mike Zheng Shou,Linchao Zhu,Haoqi Fan,Yilei Xu, Yi Yang, Zhicheng Yan

ReLER Lab, AAII, University of Technology Sydney,National University of Singapore,Meta AI,Zhejiang University

论文链接:https://arxiv.org/pdf/2203.15175v1.pdf

1、摘要

目标跟踪作为计算机视觉中的一个重要领域,已经形成了两个独立的社区,分别研究单目标跟踪(SOT)和多目标跟踪(MOT)。然而,由于两种任务的训练数据集和跟踪对象的不同,目前的一种跟踪场景的方法不容易适应另一种跟踪场景。虽然UniTrack[45]证明了可以使用具有多个头部的共享外观模型来处理单个跟踪任务,但它没有利用大规模跟踪数据集进行训练,并且在单目标跟踪上表现较差。在这项工作中,我们提出了Unified Transformer Tracker (UTT) ,以解决不同场景下的跟踪问题。我们在UTT中构架了一个Transformer Tracker在SOT和MOT中跟踪目标,利用目标特征和跟踪帧特征之间的相关性来定位目标。我们证明了SOT和MOT任务都可以在这个框架内得到解决,并且该模型可以通过在单个任务的数据集上交替优化SOT和MOT目标来同时进行端到端训练。在SOT和MOT数据集上训练了一个统一的模型,在几个基准测试上进行了广泛的实验。

🔺相比于UniTrack这篇工作解决了在SOT和MOT两个数据集上训练的问题,在SOT任务上提点明显,而MOT上还有一些差距可能是未来Unit类方法可以继续完善的地方。

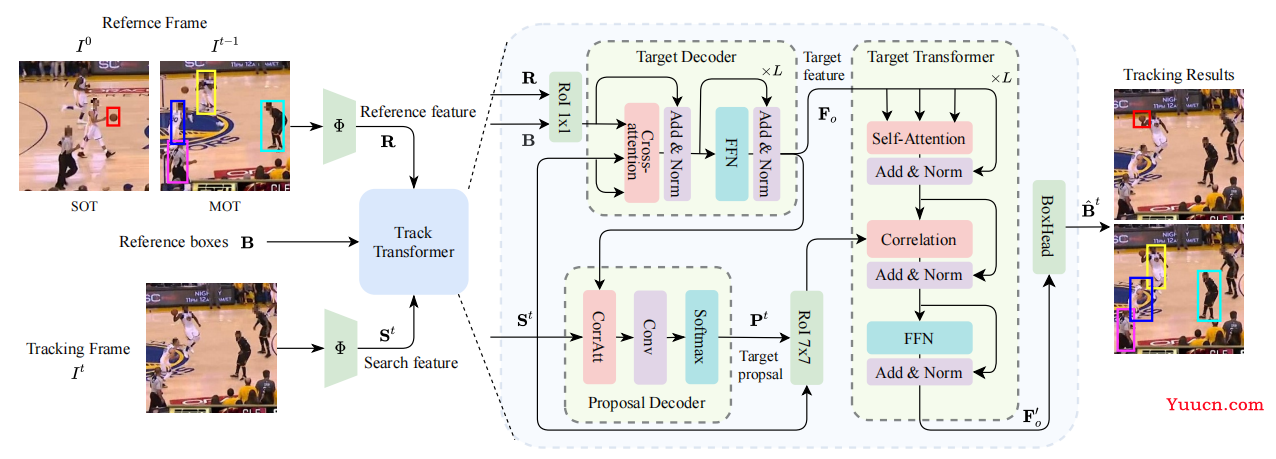

2、方法

我们首先使用主干Φ来提取帧特征。 Transformer Tracker 有三个输入,包括参考帧和跟踪帧(当前帧),以及参考帧中的目标框。Transformer Tracker的目标是预测当前帧中的目标定位。首先使用Transformer Tracker中的Target Decoder提取目标特征,Proposal Decoder在跟踪帧中产生候选搜索区域。目标特征和搜索特征都被输入Target Tansformer以预测目标定位。

该方法在MOT中还是需要一个额外的detector来完成目标的定位。

近期评论